Since a few month I own an electrical toothbrush from Phillips called Sonicare HX992B. It connects to an mobile App using Bluetooth that tells you how well you brushed your teeth, shows the orientation in real-time, and also notifies you when to change the brush for a new one. I was curious how this …

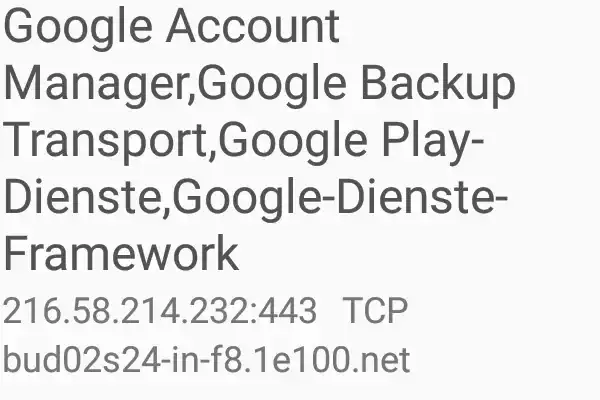

Die komische Geschichte mit der "privaten Vorratsdatenspeicherung"

mobilsicher.de hat einen Artikel veröffentlicht, über den auch heise online berichtet. Darin wird berichtet, dass Mobiltelefone mit dem Android Betriebssystem von Google bei Anrufen Daten an einen Google-Server übertragen. Sogleich wird darüber spekuliert, ob Google eine Art “private …

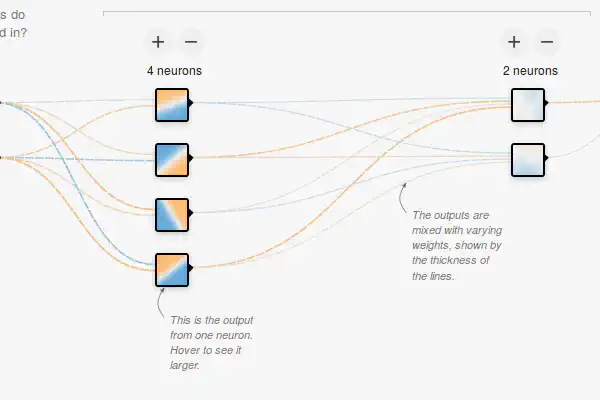

TensorFlow im Browser ausprobieren

TensorFlow, die machine learning Bibliothek von Google kann man jetzt auch direkt im Browser probieren. Ohne Expertenwissen ist es möglich mit mehreren Beispielen zu experimentieren und dabei die Parameter des Netzwerkes zu ändern oder Features hinzuzufügen oder wegzulassen. Die Seite steht zudem …

Was die NSA im HTTP/2 connection preface macht

Der Verbindungaufbau mit HTTP/2 unterscheidet sich in großen Teilen von dem bisher mit HTTP/1.1 verwendeten Vorgang. Bei cleartext Verbindungen wird das HTTP upgrade Verfahren benutzt und bei verschlüsselten Verbindungen werden bestimmte Werte innerhalb des TLS Handshakes übertragen. Was beide Arten …

Wieso mein Feedreader jetzt selbst denken kann

Anmerkung: Ich habe seit diesem Artikel Vieles dazu gelernt. Die damalige Herangehesweise konnte aus verschiedenen Gründen nicht funktionieren. Ich habe mich entschieden, den originalen Artikel trotzdem online zu lassen. Will ich mir das wirklich antun? Aber was, wenn ich die interessanten Dinge …

Die Verschwörung der Woche: Curiosity hat Wasser gefunden

Curiosity hat Wasser gefunden aber die Nasa verschweigt es!!11!!! Und ist zudem zu blöd dazu, das entsprechende Bild verschwinden zu lassen. Oder so. Das behauptet zumindest der Autor dieses höchst seriösen Videos. Der Uploader schreibt, er habe viele Bilder von Bohrungen am Mars angeschaut, aber …

Die Verschwörung der Woche: Wieso die ISS nicht existiert

In einem einstündigen (!) Video erklärt jemand, wieso die Internationale Raumstation nicht existiert und sowieso die gesammte Weltraumaktivität des Menschen Fake ist. Alle Aufnahmen sind angeblich von der NASA bei Hyperbelflügen produziert und durch Greenscreen-Technik mit einem Hintergrund versehen …

Die Android Actionbar mit Material Design

Um die alte Actionbar in einer ActionbarActivity auszublenden, bietet sich an, folgendes als Style zum Beispiel in der themes.xml anzugeben: 1<?xml version="1.0" encoding="utf-8"?> 2<resources> 3 <style name="BaseTheme" …

Wie Großbritannien mal schnell das Internet zensiert

Das Argument war, dass damit auch leicht andere, unbedenkliche Internetinhalte gesperrt werden, was einer Zensur entspricht. Der Filter lässt sich jedoch auf Wunsch des Kunden entfernen. Mitte November dann er erwartete Schritt: Auch Terrorpropaganda wird gefiltert. Wohl als Reaktion auf die …

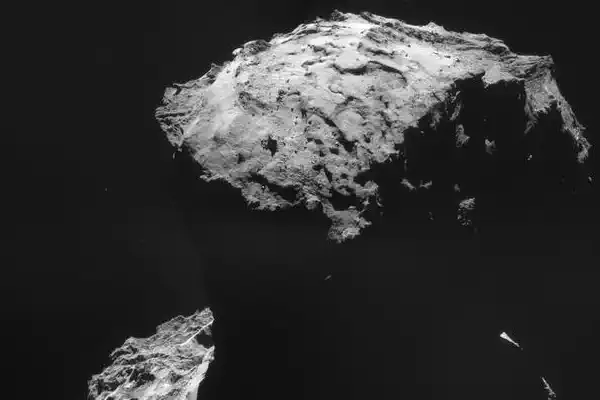

Nur noch 6 Tage bis zur Landung auf einem Kometen!

Wir wissen, ob der Lander Philae der Rosetta-Mission der ESA erfolgreich auf dem Kometen 67P/Churyumov-Gerasimenko gelandet ist. Der KometCC-BY-SA IGO 3.0 ESA/Rosetta/NAVCAM Seit 2004 ist die Mission unterwegs, um unter anderem zu erforschen, ob das Wasser der Erde oder sogar das Leben oder dessen …